Peneliti keamanan siber telah menemukan kelemahan keamanan kritis pada penyedia layanan kecerdasan buatan (AI). Mengulangi Hal ini memungkinkan pelaku ancaman mendapatkan akses ke model AI dan informasi sensitif.

“Eksploitasi kerentanan ini akan memungkinkan akses tidak sah ke perintah AI dan hasil dari semua pelanggan platform Replikasi,” perusahaan keamanan cloud Wiz dikatakan dalam laporan yang diterbitkan minggu ini.

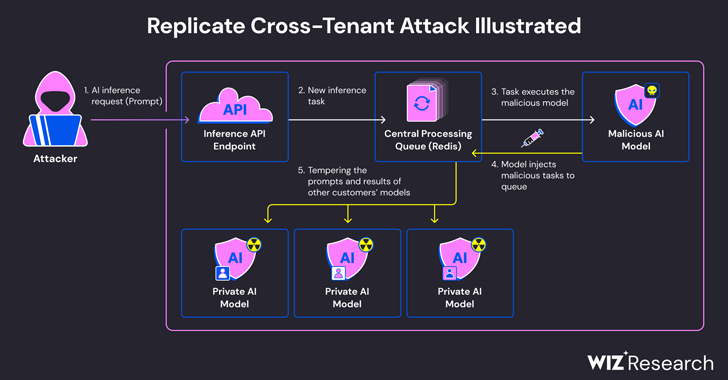

Masalahnya berasal dari fakta bahwa model AI biasanya dikemas dalam format yang memungkinkan eksekusi kode arbitrer, yang dapat digunakan oleh penyerang untuk melakukan serangan lintas penyewa melalui model jahat.

Replikasi menggunakan alat sumber terbuka yang disebut Gigi untuk memasukkan dan mengemas model pembelajaran mesin yang kemudian dapat diterapkan di lingkungan yang dihosting sendiri atau ke Replikasi.

Wiz mengatakan bahwa mereka membuat kontainer Cog jahat dan mengunggahnya ke Replikasi, yang pada akhirnya menggunakannya untuk mencapai eksekusi kode jarak jauh pada infrastruktur layanan dengan hak istimewa yang lebih tinggi.

“Kami menduga teknik eksekusi kode ini adalah sebuah pola, di mana perusahaan dan organisasi menjalankan model AI dari sumber yang tidak tepercaya, padahal model tersebut adalah kode yang berpotensi berbahaya,” kata peneliti keamanan Shir Tamari dan Sagi Tzadik.

Teknik serangan yang dirancang oleh perusahaan kemudian memanfaatkan koneksi TCP yang sudah ada dan terkait dengan instance server Redis dalam cluster Kubernetes yang dihosting di Google Cloud Platform untuk memasukkan perintah arbitrer.

Terlebih lagi, dengan server Redis terpusat yang digunakan sebagai antrean untuk mengelola beberapa permintaan pelanggan dan tanggapannya, server tersebut dapat disalahgunakan untuk memfasilitasi serangan lintas penyewa dengan merusak proses untuk memasukkan tugas-tugas jahat yang dapat berdampak pada hasil lainnya. model pelanggan.

Manipulasi jahat ini tidak hanya mengancam integritas model AI, namun juga menimbulkan risiko signifikan terhadap keakuratan dan keandalan keluaran yang digerakkan oleh AI.

“Seorang penyerang bisa saja menanyakan model AI pribadi pelanggan, yang berpotensi mengungkap pengetahuan kepemilikan atau data sensitif yang terlibat dalam proses pelatihan model,” kata para peneliti. “Selain itu, perintah penyadapan dapat mengungkap data sensitif, termasuk informasi identitas pribadi (PII).

Kekurangan tersebut, yang diungkapkan secara bertanggung jawab pada Januari 2024, telah diatasi oleh Replika. Tidak ada bukti bahwa kerentanan dieksploitasi secara liar untuk membahayakan data pelanggan.

Pengungkapannya terjadi sebulan lebih setelah Wiz terperinci risiko yang kini telah ditambal pada platform seperti Hugging Face yang memungkinkan pelaku ancaman meningkatkan hak istimewa, mendapatkan akses lintas penyewa ke model pelanggan lain, dan bahkan mengambil alih jalur integrasi berkelanjutan dan penerapan berkelanjutan (CI/CD).

“Model berbahaya mewakili risiko besar terhadap sistem AI, terutama bagi penyedia AI sebagai layanan karena penyerang dapat memanfaatkan model ini untuk melakukan serangan lintas penyewa,” para peneliti menyimpulkan.

“Potensi dampaknya sangat buruk, karena penyerang mungkin dapat mengakses jutaan model dan aplikasi AI pribadi yang disimpan dalam penyedia AI-as-a-service.”

/buzzincontent-1/media/media_files/WPihAPu5Qzx5OLvSkNNk.jpg?w=100&resize=100,75&ssl=1)